„Was muss ich eigentlich noch können?“ – das fragen sich derzeit viele, wenn wieder eine neue KI-Demo durchs Netz geht. GPT-4 kann inzwischen auf Basis einer (schlechten) Zeichnung ganze Websites programmieren, bastelt PowerPoint-Präsentationen und schreibt lesbare Romane.

In welche Kenntnisse und Fertigkeiten lohnt es sich noch, zu investieren?

Neu ist diese Frage nicht. Wir sind eine Spezies, die sich auf Experten und fertige Rezepte verlässt. Ich kann einen Bleistift benutzen, ohne zu verstehen, wie er gemacht wurde. Und ich kann eine Crème brûlée zubereiten, ohne die Grundlagen von Gerinnung und Karamellisierung zu kennen oder gar zu wissen, wie das Rezept entstand. Und wenn mir selbst das zu viel ist, übergebe ich das Problem („Nachtisch für Dinnerparty“) einem Experten, der gut darin ist, Rezepte anzuwenden.

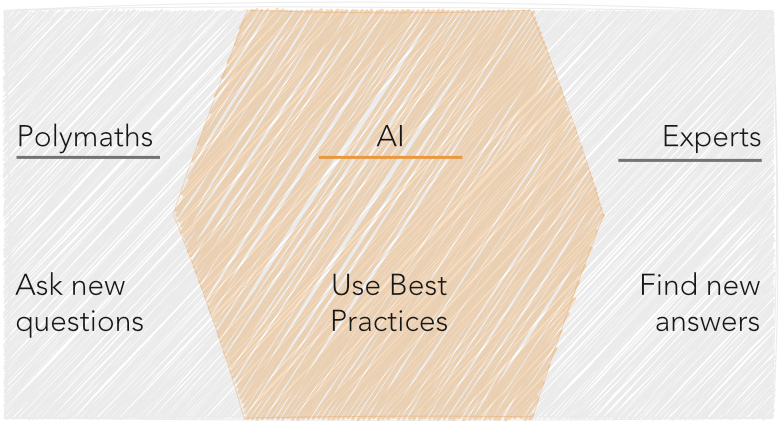

Nichts anderes machen KI-Modelle – und sie machen das bereits jetzt sehr gut. Man stellt ihnen eine Frage, das Modell wendet die „Best Practices“ (Rezepte) der Experten an – fertig! Es ist ganz offensichtlich, dass wir in Zukunft immer weniger können und wissen müssen. Die Aufgabe von Menschen wird es deswegen zunehmend sein, neue Rezepte zu finden. Neue Antworten für neue Probleme.

Aber ist das … ein Beruf? Im ersten Moment scheint das nur auf Wissenschaftler und Unternehmer zuzutreffen. Erfolgreiche Wissenschaftler zeichnen sie sich seit jeher dadurch aus, dass sie nicht nur richtig liegen, sondern dabei auch etwas Neues herausfinden. Kein Forscher wird dafür bezahlt, etwas zu sagen, was alle anderen auch sagen.1 Auf Startup-Gründer und Unternehmer trifft das Gleiche zu. Sie müssen nicht nur recht haben, sie müssen etwas sehen, dass die anderen nicht sehen.

Aber wer glaubt, dass nur die Hightech-Branche neue Probleme gepachtet hätte, unterschätzt unsere Welt. Wir alle begegnen ständig Problemen, die noch nie gelöst wurden.

Der KI-Experte Christoph Henkelmann schrieb neulich: „Wir denken, weil ein Deep Learning System unfassbar gut Proteinfaltung vorherberechnen kann, dass es ebenso verstehen können muss, ob ein Umtauschen im Supermarkt berechtigt ist. Das ist aber nicht der Fall.“2 Der Umtausch im Supermarkt ist ein ausgezeichnetes Beispiel, denn er berührt gleich drei Bereiche, die KI nur schwer übernehmen kann: Flexibilität, menschliche Intuition und ein Gespür für Ethik. Dazu mal eine typische Situation beim REWE: eine Verkäuferin gewährt dem betagten Herrn, der jeden Tag bei ihr einkauft, einen Umtausch, auch wenn er den Kassenbon verschlampt hat. In diesem Fall wendet sie alle drei Fähigkeiten (Flexibilität, Intuition, Moral) gleichzeitig an. In ein „Rezept“ gießen kann man das nur schwer.

Interdisziplinär heißt nicht, von allem eine Ahnung zu haben

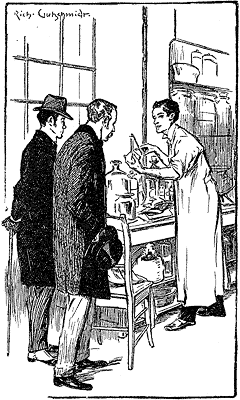

Wenn Experten auf der einen Seite der Zukunft stehen, dann stehen Generalisten auf der anderen. Was letztere auszeichnet, illustriert der Meister des interdisziplinären Denkens und Held meiner Kindheit: Sherlock Holmes.

Holmes führte chemische Versuche mit Blut durch, hatte Expertenwissen über Zigarrenasche und Londons Dreck, und er war Fachmann für Kriminalrecht. Aber er bewies auch, was interdisziplinäres Denken eben nicht ist – ein oberflächliches Wissen zu allem und jedem. Sherlock Holmes hortete zwar Wissen wie kein anderer, doch er überraschte auch regelmäßig damit, was er alles nicht wusste. Zum Beispiel, dass sich die Erde um die Sonne dreht.3

Ich möchte damit nicht gegen eine gute Allgemeinbildung argumentieren. Aber neue Ideen entstehen, wenn wir konkrete Dinge aus unterschiedlichen Bereichen neu zusammenstecken. Dafür müssen wir uns in beiden Bereich ausreichend gut auskennen.

Steve Jobs prägte das typografische Design des ersten Macintosh-Computers – und damit auch aller PCs – weil er zehn Jahre zuvor einen Kalligrafiekurs belegt hatte. Nicht, weil er irgendwo mal gelesen hatte, dass Schriftarten wichtig sind. Ein halbes Jahrtausend zuvor hatte sich Johann Gutenberg ausführlich über die Spindelpresse der Winzer informiert und kam nur deswegen auf die Idee, „aus einem Gerät zur Herstellung von Alkohol den Wegbereiter der modernen Massenkommunikation“ zu machen.4

TED Talks und Dokus können eine Inspirationsquelle dafür sein, mit welchem Thema man sich als nächstes beschäftigt – aber nicht mehr. Wer hingegen das Internet wie einen Schwamm aufsaugt, verliert seinen Vorteil gegenüber KI-Modellen. Denn die machen das Gleiche. Nur besser.

Der Beruf zu der Zukunft

In Zukunft werden wir zweierlei benötigen: Experten, die neue Antworten finden und Generalisten, die ganz neue Fragen stellen. Beides wird uns Künstliche Intelligenz nicht komplett wegnehmen.

Was heißt das für die Berufswahl? Dazu ein Zitat aus dem Film „Jim und Jules“ (1962): „Werden Sie ein Neugieriger. Das ist noch kein Beruf, aber wird bald einer sein.“

-

„He appeared to know next to nothing“, schreibt Watson im ersten Sherlock-Holmes-Roman Eine Studie in Scharlachrot. Die BBC-Serie hat den Dialog aus dem Buch weitgehend wortgetreu übernommen ↩︎

-

Quelle: Wo gute Ideen herkommen – Eine kurze Geschichte der Innovation (Steven Johnson , 2013) ↩︎